云計算概念的推廣促使數據中心逐步向高伸縮、高可用和高度資源共享的方向發展,將單個的分散的硬件設施進行整合、優化,從而形成集成的、按需分配的共享資源池已成為一種趨勢。面對新的形勢,建立用于評價數據中心建設成效并指導未來工作的數據中心指標體系越來越重要。已成為一個新的研究課題。惠普公司于近年提出了“適應性基礎設施成熟度模型(AIMM)”。AIMM旨在幫助企業評估其數據中心現狀,并根據企業的業務優先級,就企業如何達到理想的“未來狀態”制定一個可驗證的實施規劃。該模型根據行業準則的標準指標和大量的企業實踐,從運行效率、成本、服務質量和變更響應時間等方面來進行評估和衡量,將數據中心的基礎設施分為5個成熟階段,即獨立分隔的基礎設施、標準化的基礎設施、優化的基礎設施、面向服務的基礎設施和適應性、共享的基礎設施。但該模型將數據中心的技術和體系架構作為一個整體進行評估,對作為數據中心核心基礎設施的統一存儲環境的建設和運行情況卻缺乏相應的評估和指導。

NetAPP公司提供一種在NAS服務器上集成了FC、ISCSI等協議的統一存儲設備來構建統一存儲環境,以期通過一套集中存儲來完成多種應用的支撐,EMC、HDS、華賽等廠商通過在FC陣列的基礎上增加NAS控制器來構建統一存儲環境。這兩種架構都有大量的應用案例,都為統一存儲環境的建設積累了寶貴的運行經驗。

此外,非營利組織SPEC和SPC分別為NAS和FC陣列提供了性能基準測試。SPEC的基準測試為NAS提供了OPS(每秒操作數)。操作時延曲線。期望以這兩個參數及其對應關系描述設備的性能情況。相應地SPC為FC陣列提供了IOPS(每秒I/O數)。I/O時延曲線。還有一些機構為存儲設備提供了排名,這些嘗試都在為建立存儲的評估指標提供參考。

在此背景下,本文從統一存儲環境的建設實踐著手,分析了當前遇到的主要問題,從設備的高可用、高可靠和高性能等方面進行總結,并給予SPC和SPEC的基準測試提出了改進的性能指標,力圖為統一存儲環境的建設建立一套有指導意義的指標集,同時也為了推動數據中心評估指標體系的研究和建設工作。

1.統一存儲環境建設中的問題

本文將以清華數據中心為例,闡述存儲系統中存在的一些比較突出的問題。清華自2004年引入了統一存儲設備來構建統一存儲環境,以滿足FC、NFS、CIFS、ISCSI,F1P等應用并存的需求。為多變的開發運行環境提供服務保障和快速的響應時問。極大地方便了存儲系統的管理和維護。但多年的運行也暴露了該環境在高可用性、磁盤系統可靠性等方面的問題,同時應用的新需求及新技術的出現也對現有的存儲環境提出了挑戰。

1.1存儲架構不能保證高可用

統一存儲采用控制囂、磁盤系統雙冗余架構,每控制器除了可驅動自身的磁盤系統外,還可通過FC-LOOP鏈路接管另一控制器的磁盤系統。其結構如圖1所示。

圖1 雙控冗余的統一存儲架構

該結構的優點在于控制器和磁盤系統都是獨立的兩套,既可以互不干擾地獨立工作,也可以實現冗余備份功能。問題在于控制器發生故障時,NAS系統的切換時間較長,導致另一控制器接管時問長選60——180s,對于NFS應用這樣的延遲還可以恢復運行,但對于I/O響應時問敏感的Oracle教據庫等應用,會因誤判存儲發生故障而做出事故響應,導致服務中斷。

1.2性能方面存在的問題

統一存儲采用FC和NAS混用模式,在應用過程中發生過數據庫因I/O不響應宕機的問題。經分折排查,原因有兩點。一是因為統一存儲設備因將FC與NFS集成在一套設備中,當NFS或FC應用有大量寫操作時,會導致控制器CPU和緩存占用過高。從而影響其他應用。數據庫宕機是由于其對I/O響應時間敏感,因I/O響應緩慢而誤判存儲發生故障,從而中斷了服務。NFS應用因對操作時延的容忍度較高而表現稍好,往往在系統掛起一段時間后自動恢復。也出現過系統因NFS文件系統掛起而不能恢復工作的狀況。二是因為控制器的CPU及援存配置較低,出現。小馬拉大車”現象。導致控櫥過載響應緩慢,使得磁盤系統在遠沒有達到滿負荷的情況下控制器因過載而成為性能瓶頸。

1.3 磁盤系統的潛在威脅

存儲設備的磁盤大都以磁盤箱為單位。通過FC-LOOP鏈路與控制器相連。目前常見的保護措施有Raid技木、全局熱備技術以及雙FC-LOOP鏈路,可以涵蓋絕大部分磁盤系統的故障。但是磁盤箱發生故障時這些措施都將失效。磁盤箱的故障不一定會影響到磁盤的運,清華數據中心發生的磁盤箱故障就屬于這類。但磁盤箱往往附帶各種監控設備。其故障將導致控制器無法獲取磁盤的狀態信息。為恢復磁盤箱,目前只能安捧停機更換,對業務連續性影響較大。如果故障導致存儲系統崩潰。則不得不采用備用存儲或災備存儲。

1.4不能滿足自動分級的需求

早期數據中心存儲的重點在于數據集中,但經過多年的積累,數據容量激增的問題日益突出,存儲成本越來越高,尤其是歷史數據。雖然通過二級存儲可以降低維護成本,但帶來了管理和數據訪問的不方便,同時也增加了設備的維護量和能耗。而且新的應用趨勢表明,應用的數據本身也存在不同的訪問級別。完全可以分級處理。應用的發展需要更細粒度的分級處理技術支持。

2.統一存儲環境關鍵指標設計

統一存儲環境建設的目的是為了提高存儲系統可用性、性能和資源共享能力,能根據需要快速響應應用需求。能方便地管理和擴充,具有更大的彈性(伸縮性)。而云計算對存儲基礎環境的簧求也恰恰體現了這些特征。為此。本文將重點從以下4方面考慮建立相應的指標。為設備選型和架構設計提供依據。

2.1 高可用指標

(1)控制器高可用指標

首先是存儲架構,不管是NAS還是FC陣列。要實現高可用目前主要有3種架構。除圖1之外,還有2種架構,這2種架構均采用共享磁盤系統,區別在于控制器是分離的還是集成在一個背板之中。架構如圖2所示。

圖2 共享磁盤的雙拉冗余存儲架構

從架構上考慮,磁盤及控制囂雙冗余的架構可靠性最高,關鍵數據可以實現鏡像。共享背板的雙控冗余架構風險最高。磁盤及背扳都存在單點故障風險。而且背扳硬件需特制,提高了成本,優點是結構緊湊,節省了空間。性價比最高的是磁盤共享雙控冗余的集構。架構的選擇要根據實際情況而定。3種結構備有所長。對于在FC陣列基礎上增加NAS控制囂構建統一存儲環境的情況,要重點考察其FC陣列的架構。

另一個控制器的關鍵指標是控制器發生故障時的接管時間。由于NAS系統控制器切換時需接管文件系統和服務驢,切換時問較長。如有Oracle教據庫等對I/O敏感的FC應用,應避免選用統一存儲設備,或者將數據庫等高I/O敏尊的FC應用單獨采用FC陣列提供服務。以Oracle RAC為例,其對I/O響應時間要求較高,一般設置在30s左右,根據對主流FC陣列的調研,切換時間基本都控制在10s以內,切換時間指標可設定不超過20s。NAS控制器的切換時間可適當延長,根據主流廠商的調研可設置為不超過120s。

(2)鏈路高可用指標

存儲設備的鏈路涉及前端鏈路與后端鏈路。主流的存儲后端采用FC-LOOP實現磁盤與控制器的連接,為保證磁盤鏈路的可靠性和磁盤箱替換的問題,一般要求雙LOOP連接。前端鏈路FC陣列與NAS略有不同。FC陣列要求提供MultiPath FC鏈路冗余功能,而NAS的指標是IP鏈路的聚合或容錯。

(3)磁盤系統高可用指標

根據1.3節的描述,磁盤系統的典型指標有Raid技術、熟備技術和雙FC-LOOP鏈路。但針對磁盤箱的可靠性,應該要考慮兩種情況下的指標。一種是不影響存儲運行的情況,另一種是導致存儲系統崩潰的情況。針對第一種情況,要求提供可在線替換磁盤箱的技術指標,滿足該指標的技術有在線數據遷移技術,可以在不中斷服務的情況下將故障磁盤箱內磁盤上的數據遷移至其他磁盤,然后在線替換該磁盤箱。第二種情況將肯定有數據損失,為保證數據可恢復,要求提供備份或災備設備,其關鍵是RTO(服務恢復時間)和RTO指標(可恢復數據的時間點)。這兩個指標越小越好,但相應的成本也越高,實際操作中要根據數據的重要性、行業標準或國標以及可投資的預算來設定。

2.2 性能指標

SPEC和SPC組織提供主流設備的0PS和IOPS的指標,該組織鼓勵廠商提供的測試硬件能發揮出其設備的性能最大值。兩個組織的網站上公開的測試報告也可以看出,各廠商送測設備的配置有較大的差別,測試結果不能反映實際應用情況,只能作為性能的參考指標。為此,必須從多個角度綜合考慮,找到一套相對適用的性能指標。

1.2節中描述了控制器的性能瓶頸問題,反映了控制器的兩個主要性能指標,即CPU頻率和緩存大小。根據這兩個指標將廠商新型號與現有型號進行對比,以及與其他廠商同檔次設備進行比較,可以大致判斷控制器的檔次和處理能力。

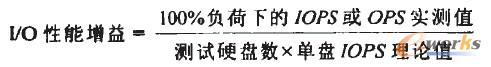

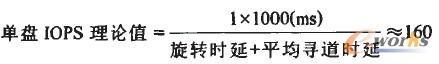

控制器配置不足會導致性能瓶頸,反過來磁盤配置不足也會導致性能瓶頸。磁盤有I/O訪問次數的物理上限,所以磁盤數量對I/O性能有顯著的影響。所以存儲設備能驅動的最大磁盤數量也是一個重要性能指標。但各廠商的最大磁盤數量不具有可比性,為保證該數據的可信度,本文在SPC和SPEC性能評測基礎上建立一個輔助指標。即I/O性能增益。該指標利用OPS/IOPS。時延曲線的數據,計算100%負荷下其IOPS/OPS實測值與理論預估值的比率。該參數可根據圖3公式計算。

圖3 IOPS/OPS實測值與理論預估值的比率計算公式

按照SPEC和SPC組織的建議,要最大化地發揮送測設備的性能表現。可以假定100%負荷下存儲設備的IOPS達到其磁盤極限。即單盤IOPS理論值。雖然磁盤本身的緩存對IOPS理論值有一定影響。但在同樣轉速的情況下基本可以忽略其影響。因此,相比于OPS和lOPS因為測試條件不同導致的不可比性,采用I/O性能增值比率可基本實現小同設備的性能比較。此參數越大,則性能表現越好。

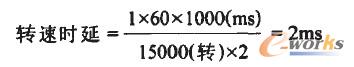

決定磁盤IOPS理論值的參數有磁盤旋轉時延、平均尋道時間以及命令的傳輸及執行時間。其中旋轉時延取磁盤旋轉一圈的平均值,以15000 RPM(每分鐘15000轉)的磁盤為例,其旋轉時延可根據圖4公式得出。

圖4 旋轉時延計算公式

平均尋道時間、命令的傳輸及執行時間均與廠商密切相關,可以從廠商得到其數值。一般這3個參數也可以歸并到平均尋道時間中。典型情況下,SAS盤與FC盤的內部機械結構相同,15000轉的磁盤為4ms左右,10000轉的磁盤為6ms左右,7200轉的SATA盤則在8.3ms左右。這樣單盤的IOPS理論值可根據圖5公式計算得出。

圖5 單盤的IOPS理論值計算公式

另一個不容忽視的問題是應用間的干擾問題。如1.2節中的FC和NFS應用互相干擾導致的數據庫宕機。該問題主要存在于采用集成FC和NFS等協議的設備環境中,如NetAPP的統一存儲設備或EMC在FC陣列上增加NAS控制器構建的統一存儲環境。針對以上類似應用場景。服務質量控制機制(QoS)是必須具備的指標,以便為高級別的應用提供預留的資源,避免資源競爭而導致服務質量下降或服務失效。

2.3 分級存儲指標

隨著歷史數據的處理要求和應用數據本身分級處理的要求不斷增加,支持數據按照使用頻率自動分級已成為當前存儲環境建設的一大重要指標。自動分級存儲已成為當前存儲虛擬化領域發展最迅速的技術之一。自動分級存儲將大量不經常活動的數據遷移至低速、低成本的磁盤系統上。將直接降低存儲的采購成本和能耗。

分級存儲的發展經過了3個階段。第一代產品是提供二級甚至多級存儲,將不經常使用的數據遷移至低檔次的存儲設備上,但此方案以來手工操作,增加了設備采購和維護工作量。第二代產品采用了lun級虛擬化,數據可在位于高速磁盤區的lun和低速磁盤區的lun之間流動,實現了在一套存儲系統內提供自動分級存儲的能力。減少了設備采購和維護工作量。但是該方案的不足之處是lun的粒度太粗。第三代產品采用塊級虛擬化技術,可以在數據塊級提供自動分級存儲。將不同級別的磁盤組成磁盤池,根據數據本身的使用頻率決定其是處于高速磁盤區還是低速磁盤區。數據塊級自動分級存儲已經得到大量成熟應用。可作為分級存儲指標。

2.4高伸縮性指標

存儲的伸縮性主要體現在性能、功能和容量的擴展3方面。性能可通過控制器數量和緩存數量擴展。FC陣列的性能擴展指標是可擴展的控制器數和緩存數。NAS控制器因需要與CPU處理能力匹配,一般緩存是固定的,其擴展指標是可擴展控制器數量。功能擴展指標包括軟件和對未來新硬件的支持能力。即存儲是否留有擴展板卡的余地。比如一些老存儲設備無法支持今天的SSD盤,影響了功能和性能的提升。容量擴展的主要指標是最大可擴展數量。對于FC陣列。很多從長遠來講,這可能是統一儲環境建設的一個技術瓶頸。

2.5兼容性指標

存儲設備的兼容性主要是主機與存儲間的FC接口和MultiPath軟件的兼容。兼容性問題來自于產品軟硬件設計缺陷或測試不全面所致,目前各廠商提供其產品的兼容性列表,但用戶方還沒有一個規范性的兼容性列表要求,導致選型時工作量極大,甚至在設備安裝后遇到難以解決的兼容性問題,將兼容性列表作為指標需要了解不同行業的系統環境,有較大的難度。目前的解決方案是針對行業區別對待。

3.實驗與結果分析

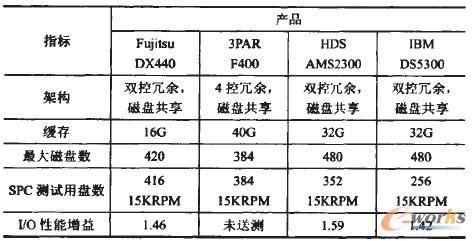

根據SPC評測數據計算各廠商FC陣列的I/O性能增益,找到數值比較接近的產品,同時根據本文中的性能相關存儲指標,進一步判斷廠商所提供的產品是否處于同一檔次。根據SPC評測數據得到的結果見表l。

表1 性能指標接近的中端FC陣列

3PAR的F400在國內比較少見,但根據該表很容易地判斷其所處檔次,從而為設備選型提供參考。

4.結束語

統一存儲環境的建設已有不短的時間,但統一存儲環境的建設指標卻是一個新課題。本文從清華大學數據中心運行維護工作中遇到的問題出發,對統一存儲環境建設過程中出現的各類問題進行分析匯總,從存儲架構的高可用性、性能需求、分級存儲需求、伸縮性和兼容性等方面加以闡述論證,提出了存儲架構高可用指標、鏈路高可用指標、磁盤系統高可用指標、性能指標、分級存儲指標、伸縮性指標和兼容性指標,力圖為統一存儲環境建設建立一套適用的參考指標體系。但限于作者的經驗及考察的范圍和應用案例,這項工作仍有很大的改進余地,在架構設計、性能評估、高伸縮性、應用集成等方面還有許多工作值得研究。對該課題的持續研究不僅對存儲技術的發展有促進作用,也為數據中心的建設模式和思路提供了參考,有助于促進對新一代數據中心建設具有指導意義的指標體系的研究。

核心關注:拓步ERP系統平臺是覆蓋了眾多的業務領域、行業應用,蘊涵了豐富的ERP管理思想,集成了ERP軟件業務管理理念,功能涉及供應鏈、成本、制造、CRM、HR等眾多業務領域的管理,全面涵蓋了企業關注ERP管理系統的核心領域,是眾多中小企業信息化建設首選的ERP管理軟件信賴品牌。

轉載請注明出處:拓步ERP資訊網http://www.lukmueng.com/

本文標題:數據中心統一存儲環境的關鍵指標研究